Seit gut drei Jahren betreibe ich einen RaspberryPi als Homeserver. Zunächst reichte dieser noch gut aus. Mit der Zeit wurde aber nicht nur die Zahl der Anwendungen, die auf dem Raspberry laufen, mehr, sondern auch die Leistungsanforderungen der Anwendungen selbst. Besonders meine ich damit die Influx Datenbank, die seit über drei Jahren jede Minuten um einen Datensatz der PV-Anlage größer wird. Die Datenbank braucht mittlerweile über 10 Minuten zum Starten. Auch diese Webseite braucht zum Laden deutlich länger, als sie sollte. Wenn ich den Raspberry komplett neu starte, braucht es ca. eine Stunde, bis alle Anwendungen wieder laufen. Das ist definitiv zu viel. Es sollte also ein neuer Rechner her. In dieser Artikelserie möchte ich davon berichten.

Übersicht aller Artikel dieser Serie

- Teil 1 – Die Hardware

- Teil 2 – Installation von Proxmox

- Teil 3 – Openmediavault

- Teil 4 – Ubuntu Server

- Teil 5 – Docker und Portainer

- Teil 6 – Homarr

- Teil 7 – Unifi Controller

- Teil 8 – Pihole

- Teil 9 – Jellyfin

- Teil 10 – InfluxDB und Grafana

- Teil 11 – Homeassistant

- Teil 12 – Mosquitto

- Teil 13 – WireGuard mit wg-easy

- Teil 14 – Immich

- Teil 15 – Stromverbrauch

Installation von Docker

Auf meinem zuvor eingerichteten Ubuntu Server installiere ich nun Docker. Die Installation ist in der Dokumentation von Docker sehr gut erklärt. Die dort aufgeführten Befehle kann man so eins zu eins ins Terminal kopieren und ausführen, also:

|

1 2 3 4 5 6 7 8 9 10 11 12 13 |

# Add Docker's official GPG key: sudo apt-get update sudo apt-get install ca-certificates curl gnupg sudo install -m 0755 -d /etc/apt/keyrings curl -fsSL https://download.docker.com/linux/ubuntu/gpg | sudo gpg --dearmor -o /etc/apt/keyrings/docker.gpg sudo chmod a+r /etc/apt/keyrings/docker.gpg # Add the repository to Apt sources: echo \ "deb [arch=$(dpkg --print-architecture) signed-by=/etc/apt/keyrings/docker.gpg] https://download.docker.com/linux/ubuntu \ $(. /etc/os-release && echo "$VERSION_CODENAME") stable" | \ sudo tee /etc/apt/sources.list.d/docker.list > /dev/null sudo apt-get update |

und

|

1 |

sudo apt-get install docker-ce docker-ce-cli containerd.io docker-buildx-plugin docker-compose-plugin |

Jetzt ist Docker schon fertig installiert.

Installation von Portainer

Jetzt installiere ich Portainer nach dieser Dokumentation.

Zuerst erstellen wir ein Volume:

|

1 |

sudo docker volume create portainer_data |

Dann kann Portainer schon installiert und gleichzeitig gestartet werden:

|

1 |

sudo docker run -d -p 8000:8000 -p 9443:9443 --name portainer --restart=always -v /var/run/docker.sock:/var/run/docker.sock -v portainer_data:/data portainer/portainer-ce:latest |

Konfiguration von Portainer

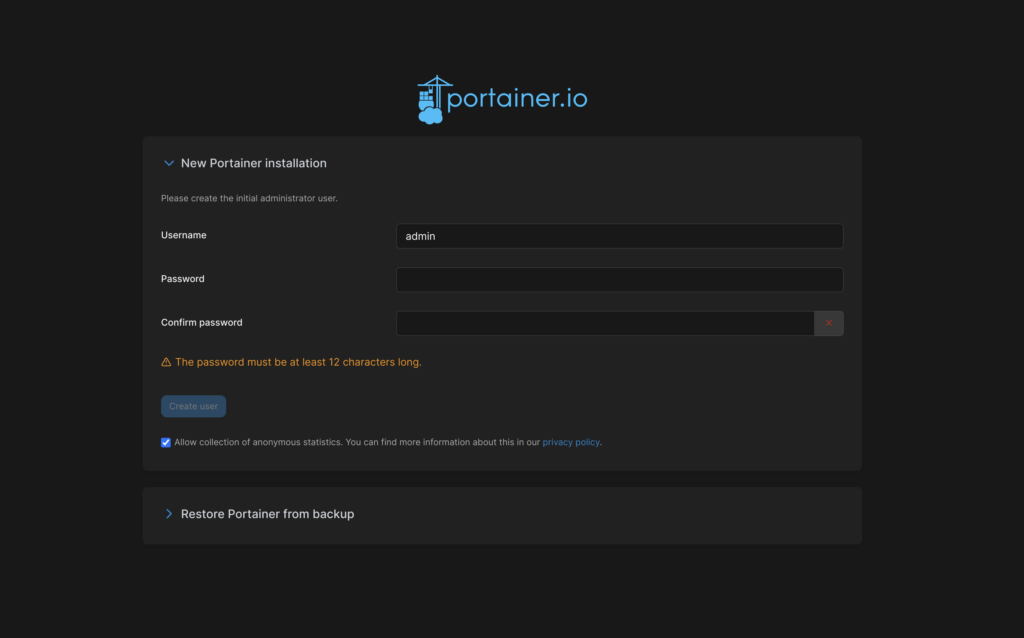

Die Admin-Seite von ist jetzt unter https://IP_ADRESSE:9443 erreichbar. Dort lässt sich ein Admin-Konto mit Passwort anlegen.

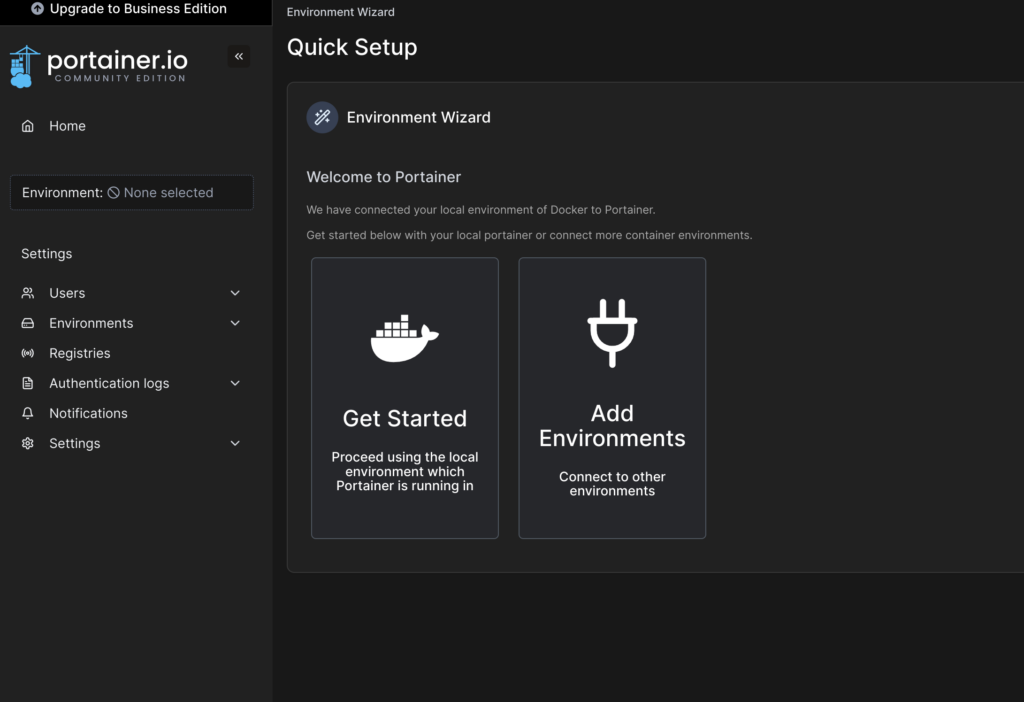

Im nächsten Screen klicke ich auf „Get startet“, da ich Portainer nur für meine lokale Docker Instanz verwenden möchte.

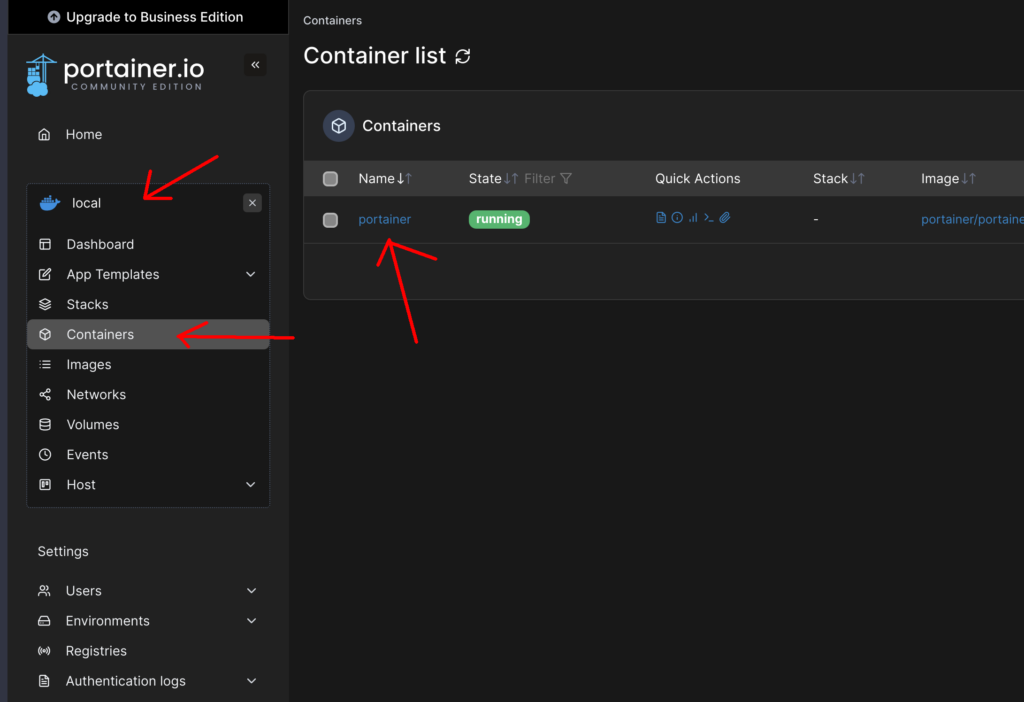

Unter „local“→“Containers“ sieht man alle Dockercontainer. Bisher eben nur einen einzigen – nämlich Portainer selbst.

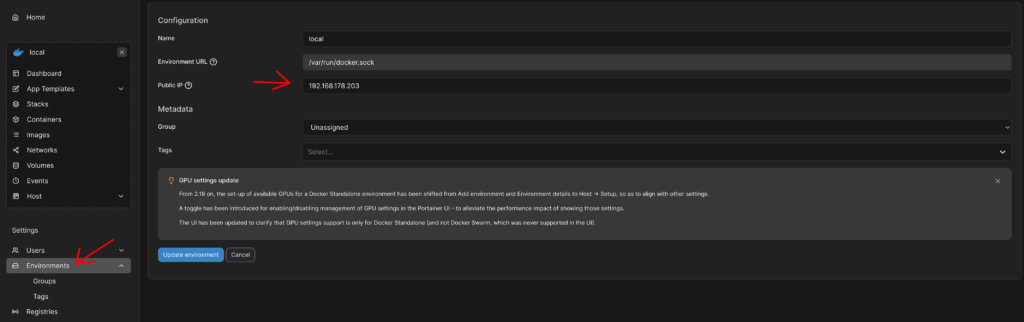

Leitet man Ports von einem Container an den Host weiter, so werden diese Ports in der Übersicht (Bild oben) klickbar dargestellt. Standardmäßig zeigen diese Links aber auf die IP-Adresse „0.0.0.0“. Das kann man ändern unter „Settings“→“Environments“→“local“. Dort kann man seine IP-Adresse angeben. Dann funktionieren die Links in der Übersicht auch.

Portainer und Docker sind jetzt fertig. Wir können jetzt unsere Container bequem in der grafischen Oberfläche erstellen und konfigurieren. Als ersten Container installiere ich homarr, eine Dashboard-Software, damit ich alle meine Programme im Überblick habe.

13. Juli 2025 um 15:36 Uhr

Danke dass du das Setup deines Homeservers hier dokumentiert hast.

In Zeiten wo einfache Informationen und Anleitung gefühlt nur noch bei Youtube vorhanden sind ist das sehr hilfreich.

Ich habe eine Frage:

Du hast Proxmox als Grundlage in dem die VMs für Open Media Vault und Ubuntu laufen hast.

Wieso hast die die einzelnen Dienste nicht direkt in den Proxmox Containern installiert?

Stattdessen hast du alles unter Ubuntu in Docker Containern laufen. Soweit ich weiß hast du die Gründe dafür nicht pennant.

Ich plane demnächst eine Erweiterung meines Servers (Evtl. auch neue Hardware) und plane etwas ähnliches. Zur Zeit laufen nur Adquard, Paperless und ein Samba-Server der dem OMV weichen wird.

Danke dir schon mal im Voraus.

20. Juli 2025 um 11:59 Uhr

Hi sorry für die späte Antwort, war im Urlaub.

Da ich nicht alles in Containern laufen lasse – z.B. den Webserver mit Nextcloud brauche ich die Ubuntu VM sowieso. Diesen hab ich deswegen klassisch installiert, weil ich es vorher auch schon so hatte. (Mir fällt grad auf, dass ich zu Nextcloud gar nichts geschrieben hab).

Da ich immer mal wieder Probleme mit Ausfällen hatte, was sich darin äußerte, dass einfach gar nichts mehr ging und ich den Stecker ziehen musste, wollte ich an Proxmox so wenig wie möglich ändern, um zu verhindern, dass ich durch irgendeine Fehlkonfiguration für diese Abstürze sorge. Bzw., dass dann nur die VM abstürzt und ich per Remote diese dann neu starten kann. Deswegen habe ich nur die zwei VMs erstellt und sonst an Proxmox nichts verändert.

Diese Abstürze hatte ich über verschiedene Hardware (Raspberry Pi und Mini-PC) und verschiedene Betriebssysteme (Ubuntu, Debian und jetzt eben Proxmox).

Das Ganze hat leider nichts gebracht. Alle paar Monate stürzt das Ding trotzdem ab. Ich hab seit kurzem OMV auf einen separaten Tower-PC ausgelagert. Dieser ist bisher noch nicht abgestürzt. Den einzigen Grund, den ich mir jetzt noch für die Abstürze vorstellen kann, sind Spannungsschwankungen im Stromnetz, die möglicherweise die Steckernetzteile von MiniPC und Raspberry nicht gut abbekommen, das „große“ PC-Netzteil aber schon. Aber ich schweife ab:

Grund das Ganze in VMs zu installieren war primär möglichst wenig am Grundsystem zu ändern, um die Ausfallquote niedrig zu halten.